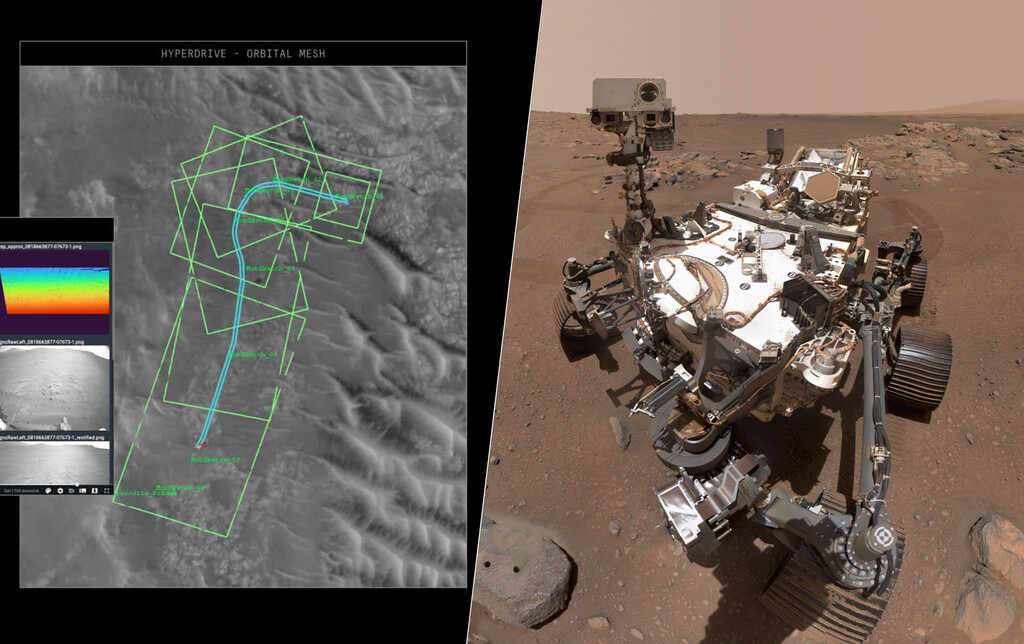

Durante los últimos años, la inteligencia artificial se ha colado en nuestras rutinas como una herramienta práctica: genera imágenes, resume, analiza, programa. Pero en los últimos tiempos está cruzando una frontera más exigente, la de los sistemas que toman decisiones con consecuencias físicas en el mundo real. Y eso también incluye el espacio. El JPL de la NASA acaba de anunciar de que el rover Perseverance ha completado las primeras conducciones en otro mundo cuya ruta fue planificada por IA. En términos de exploración planetaria, no hablamos de un gran salto en distancia, sino de algo más delicado: probar que una tecnología pensada para interpretar información y proponer acciones puede empezar a integrarse, con supervisión, en la forma en la que se exploran otros mundos.

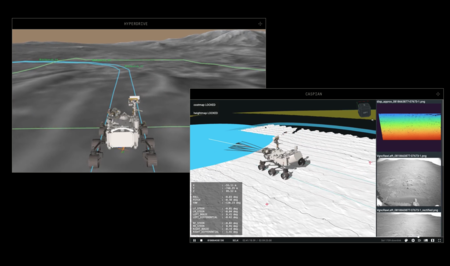

Qué hizo exactamente la IA. La prueba se materializó en dos conducciones realizadas el 8 y el 10 de diciembre de 2025, ambas dentro del cráter Jezero. En esos dos días, el equipo incorporó modelos de IA con capacidad visual para una tarea muy concreta: proponer waypoints, es decir, las ubicaciones intermedias sobre las que después se construye el plan de conducción que se envía al rover. Este tipo de planificación normalmente se hace de forma manual por especialistas que analizan imágenes y datos del terreno. En esta ocasión, la IA generó esos puntos de paso para que Perseverance pudiera navegar con seguridad por una zona compleja, bajo el liderazgo del propio centro de operaciones del rover en JPL y en colaboración con Anthropic.

Una limitación básica. Marte está lejos, y no se puede conducir un rover como si fuera un coche teledirigido. El propio JPL recuerda que el planeta rojo está, de media, a unos 225 millones de kilómetros de la Tierra, una distancia que genera retrasos en la comunicación y hace inviable el control en tiempo real. Por eso, las misiones operan con una lógica distinta: se analiza el terreno, se trazan rutas por tramos y se envían instrucciones a través de la Red del Espacio Profundo. El rover las ejecuta y el resultado se confirma con retraso. Es un flujo de trabajo muy probado, pero también lento, especialmente cuando el objetivo es avanzar por zonas complejas sin poner en riesgo el vehículo.

Las cifras del hito. El JPL detalla que, en la primera demostración del 8 de diciembre de 2025, Perseverance avanzó unos 210 metros. En la segunda, el 10 de diciembre, recorrió alrededor de 246 metros. En total, algo más de cuatrocientos metros en dos jornadas. No es una gesta épica ni pretende serlo. Lo relevante es que esos recorridos se apoyaron en un esquema distinto al habitual: la planificación se construyó a partir de los mencionados waypoints y el rover ejecutó después el plan sobre un terreno que exige precisión porque no perdona errores.

Una demostración de que la IA sigue ganando terreno. “Esta demostración muestra hasta qué punto han avanzado nuestras capacidades y amplía la forma en que exploraremos otros mundos.”, afirmó el administrador de la NASA, Jared Isaacman. Y remató con una idea que funciona como guía editorial de todo el experimento: “Tecnologías autónomas como esta pueden ayudar a las misiones a operar de manera más eficiente, responder a terrenos desafiantes y aumentar el rendimiento científico a medida que aumenta la distancia de la Tierra”. Por ahora, la demostración es limitada, pero es difícil no leerla como un aviso. La autonomía ya no se discute solo en los laboratorios, también se está probando en Marte.

En contexto. No hablamos de cualquier IA. Claude, los modelos Anthropic, llevan tiempo ganando terreno como herramienta para tareas de programación, convirtiéndose en una opción de referencia, incluso amenazando a ChatGPT. Y esa reputación no se ha quedado en la comunidad de desarrolladores: según Mark Gurman (Bloomberg), Apple lo estaría empezando a integrar de forma estructurada en su estrategia de IA para Xcode; y, de acuerdo con Insider, Meta ha incorporado Claude en “Devmate”, una herramienta interna orientada a depuración.

Imágenes | NASA | Anthropic

-

La noticia Claude empieza a parecer imparable: la NASA ya lo ha usado para planificar rutas del rover Perseverance en Marte fue publicada originalmente en Xataka por Javier Marquez .

☞ El artículo completo original de Javier Marquez lo puedes ver aquí